本記事の内容

本記事では、初めてAuto Scalingを扱う人やAWS認定資格取得を目指す方向けに、Auto Scalingの基礎知識を解説します。

- 構成要素

- 特徴/利用シーン

- 利用料金

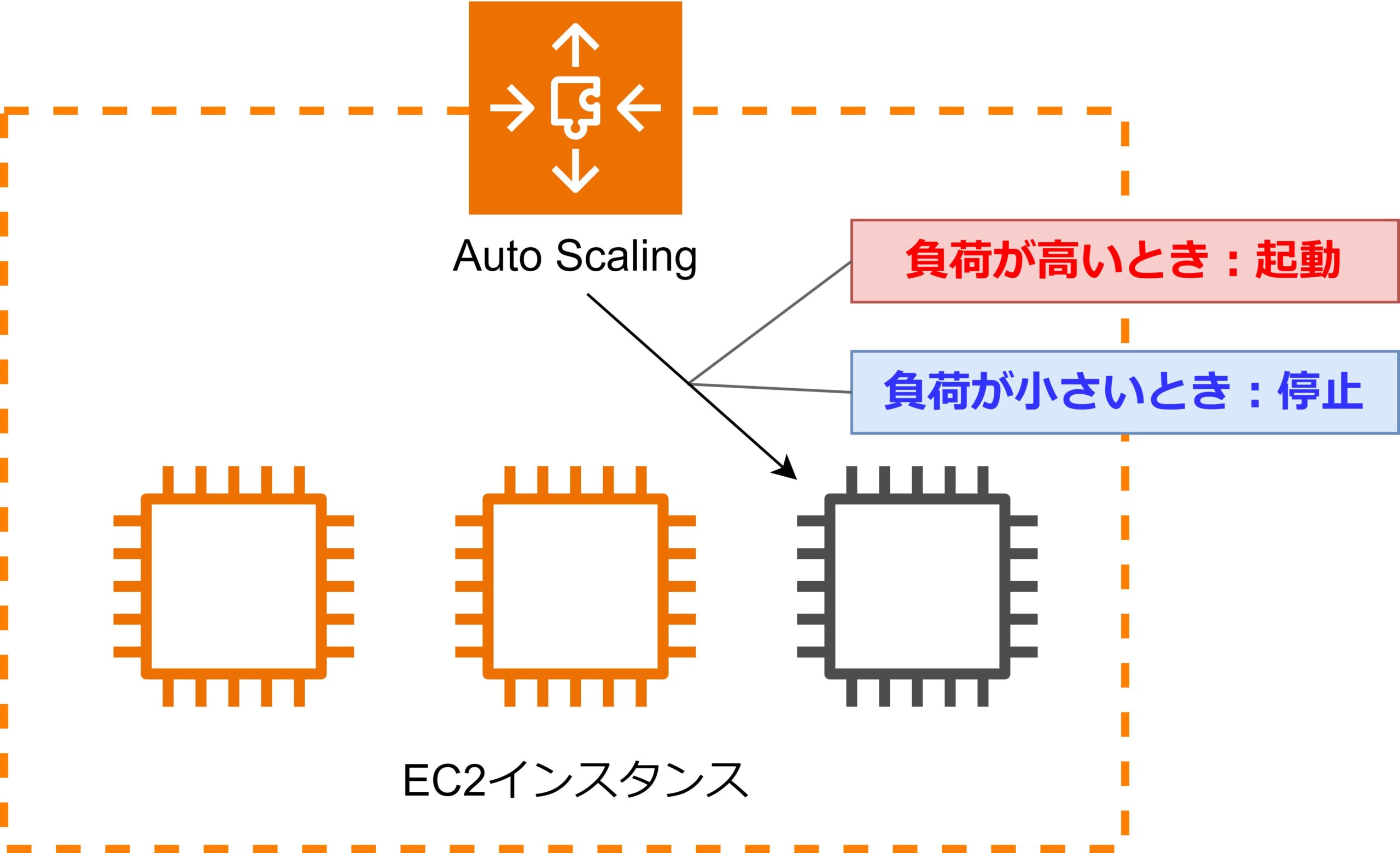

Auto Scalingの概要

Auto Scalingは、アプリケーションの負荷に応じて自動的にサーバーの数を増減させる仕組みです。これにより、リソースを最適に管理し、コストを削減しながらアプリケーションの高可用性を維持できます。

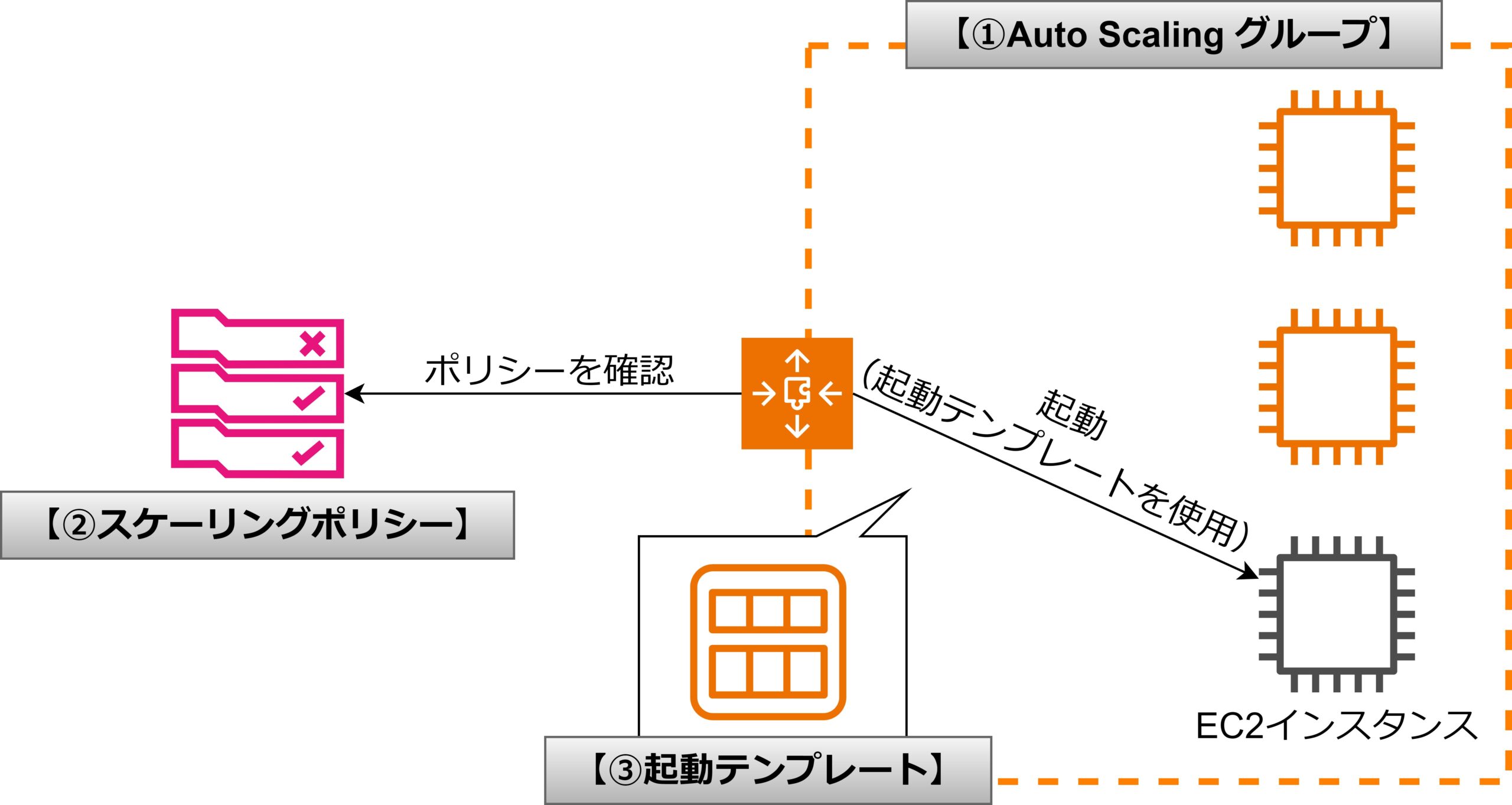

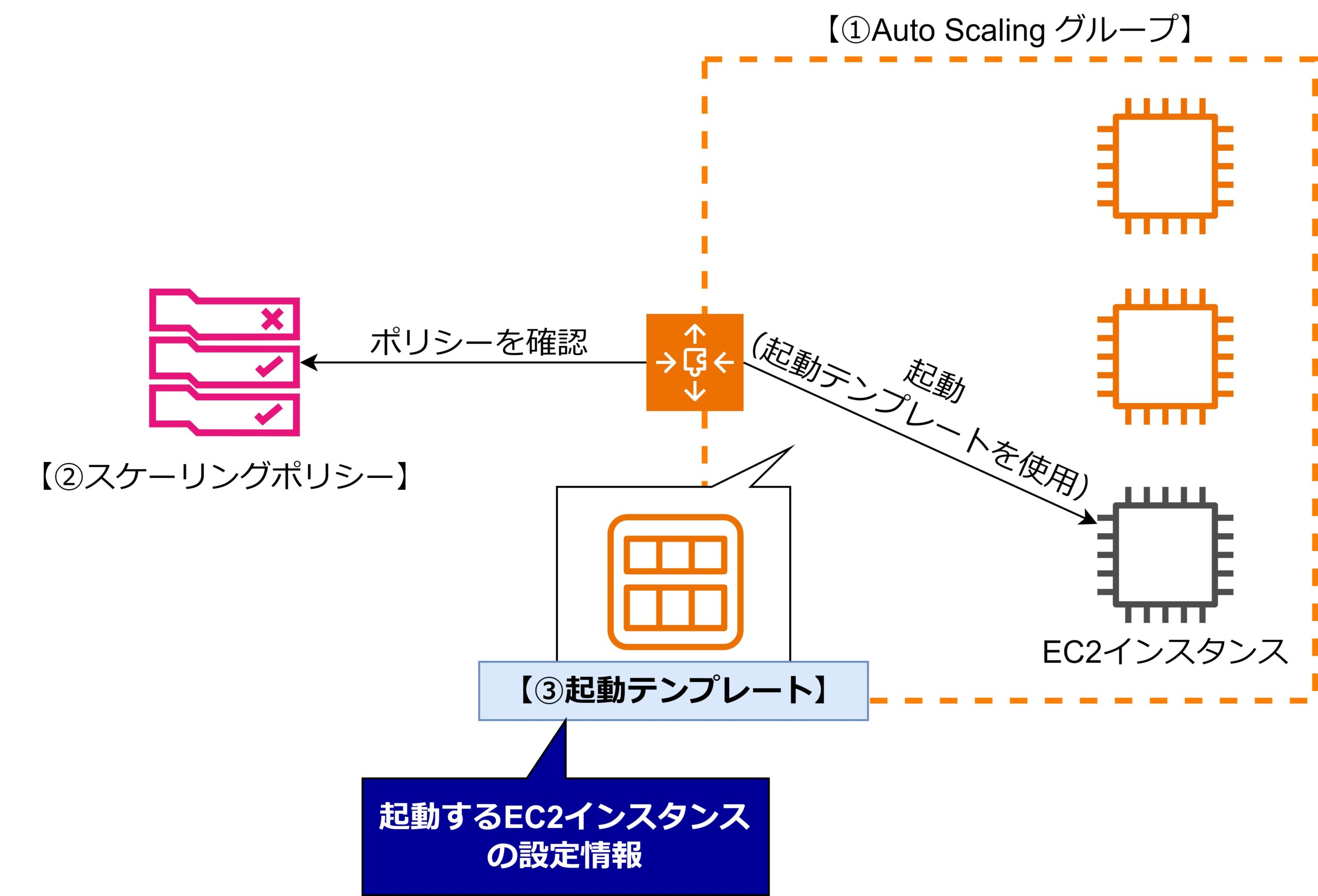

Auto Scalingの構成要素

Auto Scalingは以下の要素で構成されます。設定項目を解説する前に、Auto Scalingの全体像を抑えましょう。

- Auto Scalingグループ

- スケーリングポリシー

- 起動テンプレート

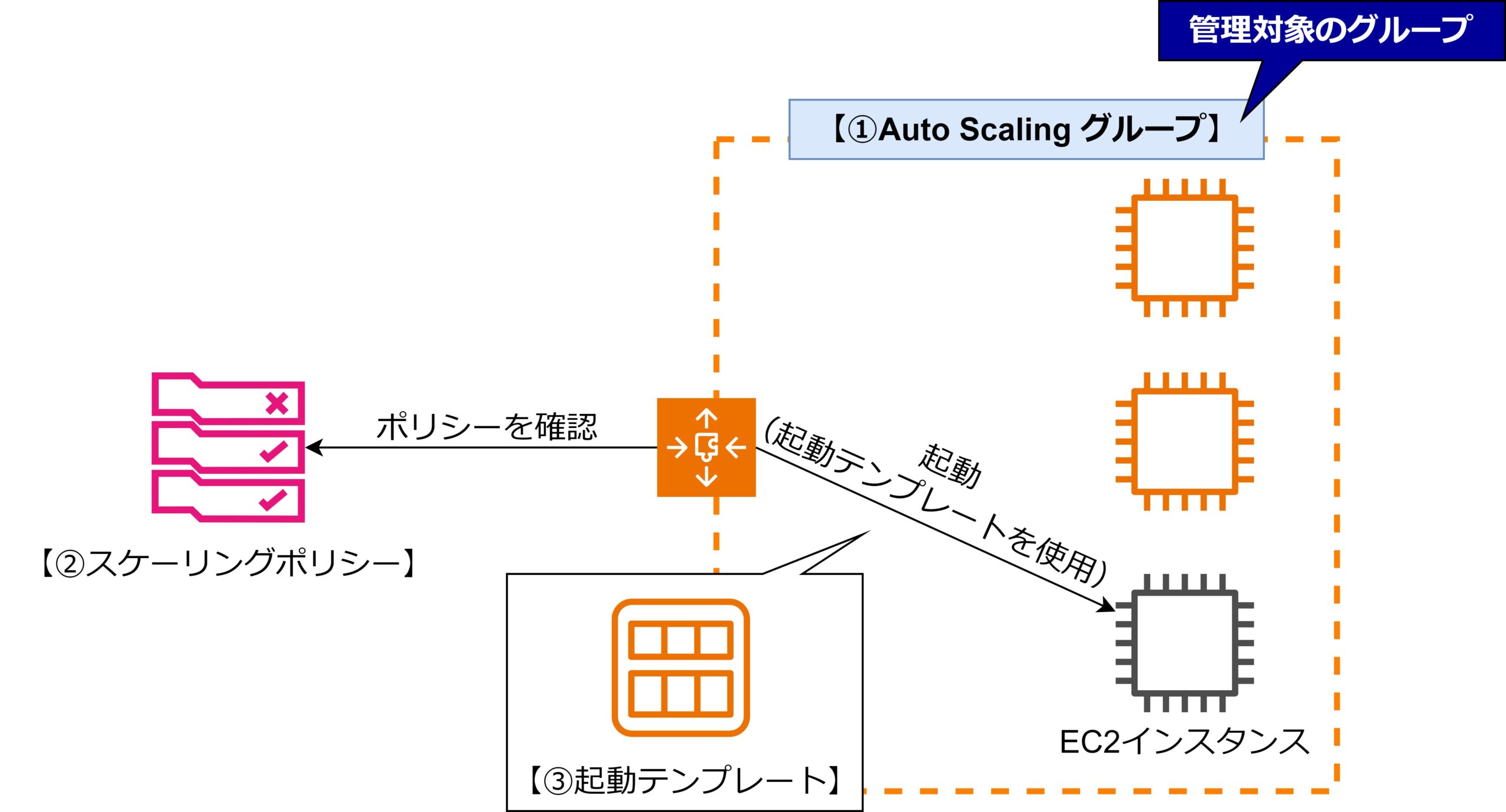

①Auto Scalingグループ

Auto Scalingグループは、管理対象のEC2インスタンスのグループです。

起動するインスタンスの最小数、最大数を設定し、トラフィックに応じてインスタンスの自動スケーリングを行います。インスタンスが障害で停止した場合、新しいインスタンスが自動で起動されます。

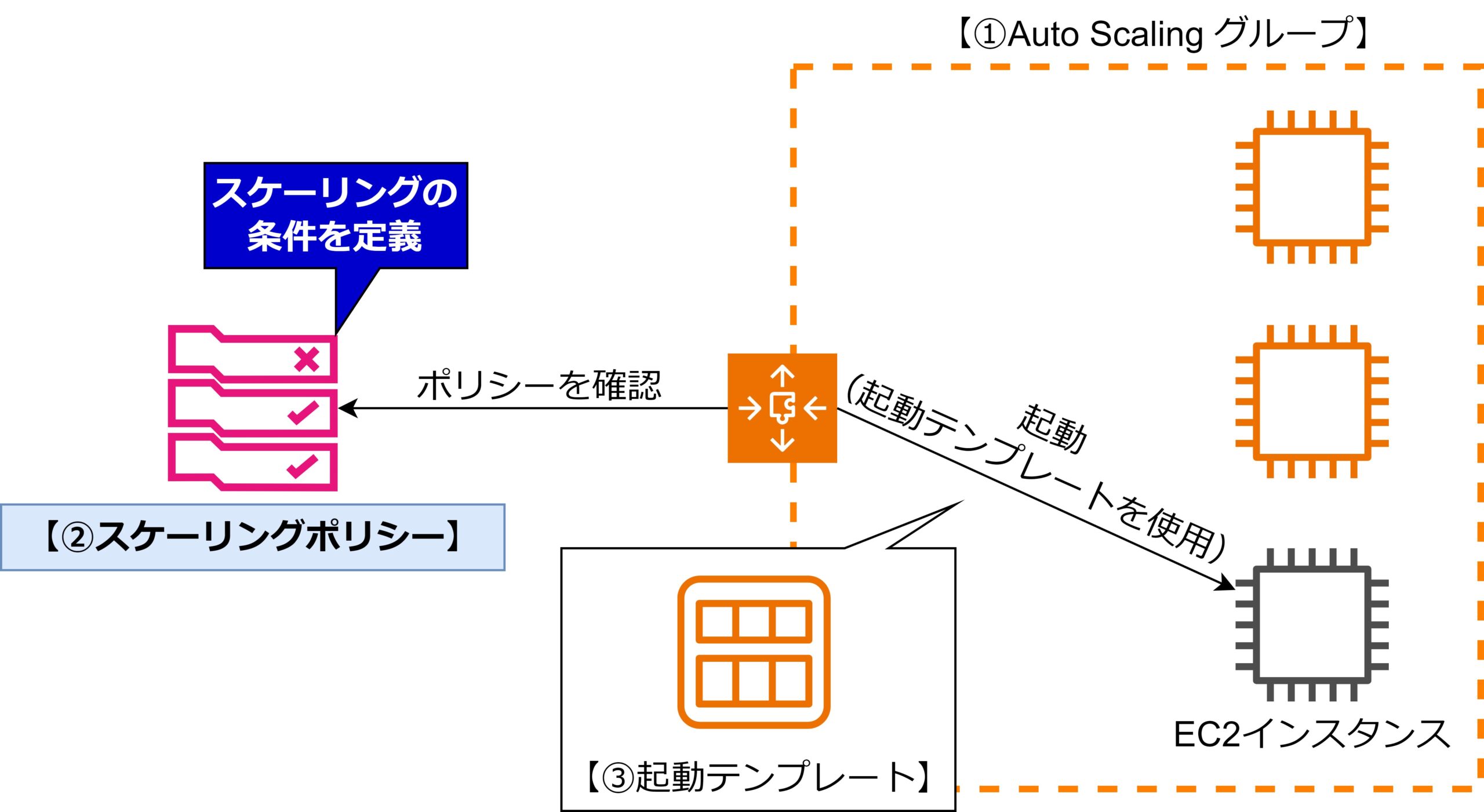

②スケーリングポリシー

スケーリングポリシーは、スケーリングの条件を定義するルールです。

CPU使用率やネットワークトラフィックなどのメトリクスに基づいて、インスタンスを追加・削除するタイミングを設定します。スケーリングポリシーにより、需要に応じたリソースの増減が自動で行われます。

③起動テンプレート

起動するEC2インスタンスの設定情報を定義します。

インスタンスタイプ、AMI(Amazon Machine Image)、キーのペア、セキュリティグループなど、インスタンス起動時の設定が含まれます。このテンプレートを基にAuto Scalingグループがインスタンスを起動します。

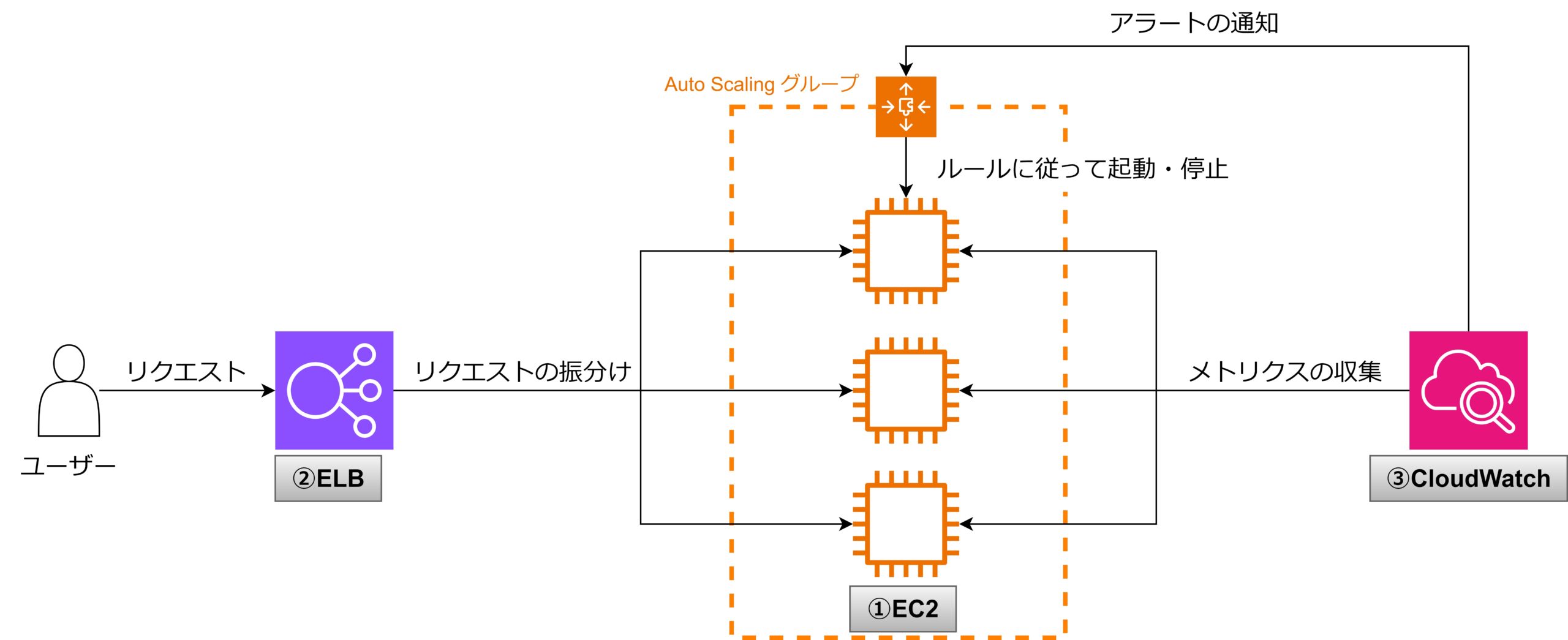

Auto Scalingと併せて利用するAWSサービス

Auto Scalingと併せて利用される、代表的なAWSサービスを解説します。

- EC2

- ELB

- CloudWatch

①EC2

EC2は、AWSの仮想サーバーサービスで、さまざまなインスタンスタイプから選択して、アプリケーションやシステムをホスティングすることができます。

Auto ScalingによってEC2インスタンスが自動的に追加・削除され、システムの負荷に応じた柔軟なリソース管理が可能になります。起動テンプレートやスケーリングポリシーを使用して、最適なインスタンスが起動されます。

EC2については、以下の記事で概要や構成要素を図解しているので、詳しく知りたい方はご覧ください。

②ELB

ELBは、複数のEC2インスタンスにトラフィックを自動で分散するロードバランサーです。

Auto Scalingによってインスタンスが追加・削除された場合に、新しいインスタンスにも自動的にトラフィックを分散します。これにより、スケールアウトしたリソース全体に負荷が均等にかかるように調整されます。

ELBには、ALB・NLB・CLBの3種類があります。

このうちALBについては概要や構成要素を図解しているので、詳しく知りたい方はご覧ください。

③CloudWatch

CloudWatchは、AWSリソースやアプリケーションのパフォーマンスを監視するサービスです。

Auto Scalingは、CloudWatchメトリクス(CPU使用率やメモリ使用率など)に基づいてスケーリングの判断を行います。例えば、CPU使用率が高いときに新しいインスタンスを追加するなど、CloudWatchのアラームとスケーリングポリシーを連動させて自動化を行います。

Auto Scalingの特徴

Auto Scalingは動的なシステムに対して非常に有用であり、システムの安定性と柔軟性を高めることができます。

- 自動的なスケーリング

- 高可用性の確保

- 柔軟なスケーリングポリシー

- コスト効率の向上

特徴①:自動的なスケーリング

トラフィックやリソース使用量に応じて、EC2インスタンスなどのリソースを自動的に追加・削除します。これにより、需要に応じたリソースの最適化が行われ、システムのパフォーマンスとコストのバランスを維持できます。

特徴②:高可用性の確保

Auto Scalingは、インスタンスの障害や停止時に自動で新しいインスタンスを起動し、システムの可用性を保ちます。これにより、システムが常に稼働し続けるため、ダウンタイムが最小限に抑えられます。

特徴③:柔軟なスケーリングポリシー

Auto Scalingは、スケーリングのルール(ポリシー)を柔軟に設定できます。例えば、CPU使用率やメモリ利用率などの特定のメトリクスに基づいてスケーリングを行う動的スケーリングや、特定の日時に合わせてスケーリングを行うスケジュールベースのスケーリングが可能です。

- ターゲット追跡スケーリング

- 指定したメトリクス(CloudWatch)の目標値に基づいてリソースをスケールします。

- 例えば、CPU使用率が50%を目標とする場合、それを維持するためにインスタンスの数を自動で調整します。

- ステップスケーリング

- トリクスの増減幅に応じて、ステップごとにスケーリングを行う方式です。

- 例えば、CPU使用率が60%を超えたら1台のインスタンスを追加し、80%を超えたらさらに2台追加するなど、メトリクスの変動に合わせてインスタンス数を段階的に調整します。

- シンプルなスケーリング

- 特定のメトリクスが閾値に達したときに、1つのアクション(インスタンスの追加または削除)を行います。

- 例えば、CPU使用率が80%を超えた場合にインスタンスを1台追加するというように、単純な条件に基づいてスケーリングします。

特徴④:コスト効率の向上

必要なリソースだけを自動で確保するため、リソースの過剰な確保や無駄なコストを抑えつつ必要に応じてスケールアップできるため、効率的なリソース管理が可能です。

Auto Scalingの利用例

Auto Scalingを利用することで、システムのパフォーマンス維持とコスト効率の両立を実現する例を紹介します。

利用例①:Webアプリケーションのトラフィック増減への対応

- ● 背景

-

Webアプリケーションでは、時間帯やイベント(セール、キャンペーンなど)によってアクセスが急増・急減することがよくあります。この変動に対応できないと、サイトのパフォーマンスが低下し、ユーザーの離脱や売上の減少につながります。

- ● メリット

-

トラフィックの増加時にインスタンスを自動的に追加してパフォーマンスを維持できます。

- ● 注意点

-

スケールアウト時の新しいインスタンスの起動速度や、適切な負荷分散設定を考慮する必要があります。

利用例②:バックエンドのバッチ処理

- ● 背景

-

大規模なデータ処理や分析、バックアップなど、特定の時間や条件下で多くのリソースが必要なバッチジョブが発生します。またリソースが不足すると処理時間が長くなり、業務効率が悪化します。

- ● メリット

-

ピーク時のみ必要なリソースを動的に提供でき、バッチ処理終了後にリソースを自動で削減し、コストを最小限に抑えられます。

- ● 注意点

-

バッチ処理中にスケーリングの遅れがないよう、事前に計画されたスケジュール型スケーリングの活用も検討する必要があります。

Auto Scalingの料金

Auto Scaling自体には料金は発生しません。

参考記事

本記事の解説は以上です。

ここからは、より知識を深めたい人向けに関連記事を紹介します。

関連するAWSサービス

Auto Scalingは、EC2やELB, CloudWatchといったサービスと併せて利用されます。

これらのサービスについては概要や構成要素を図解しているので、詳しく知りたい方は以下の記事をご覧ください。

コメント